Link to original video by Stanford Online

Stanford CS25: V4 I Aligning Open Language Models

Tóm tắt video "Stanford CS25: V4 I Aligning Open Language Models"

Tóm tắt ngắn:

- Video trình bày về chủ đề "Căn chỉnh các mô hình ngôn ngữ mở" (Aligning Open Language Models), một chủ đề nóng hổi trong lĩnh vực AI hiện nay.

- Video thảo luận về các kỹ thuật và mô hình được sử dụng để cải thiện khả năng sử dụng của các mô hình ngôn ngữ mở, bao gồm Alpaca, QLoRA, DPO, PPO và nhiều kỹ thuật khác.

- Video cũng đề cập đến các ứng dụng và tác động của việc căn chỉnh các mô hình ngôn ngữ mở, bao gồm việc tạo ra các mô hình có khả năng tương tác tốt hơn với người dùng và giải quyết các vấn đề về an toàn.

- Video mô tả chi tiết các phương pháp và kỹ thuật được sử dụng trong quá trình căn chỉnh mô hình, bao gồm việc sử dụng dữ liệu tổng hợp, tối ưu hóa trực tiếp ưu tiên (DPO) và tối ưu hóa chính sách (PPO).

Tóm tắt chi tiết:

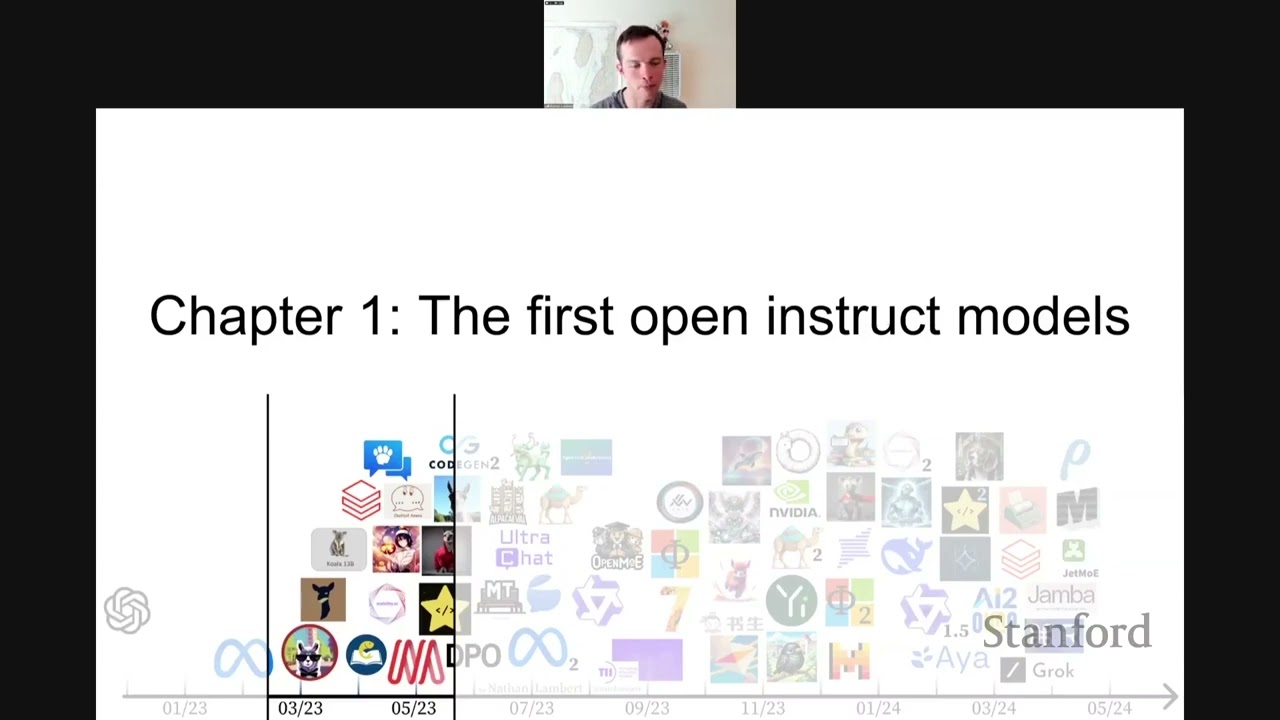

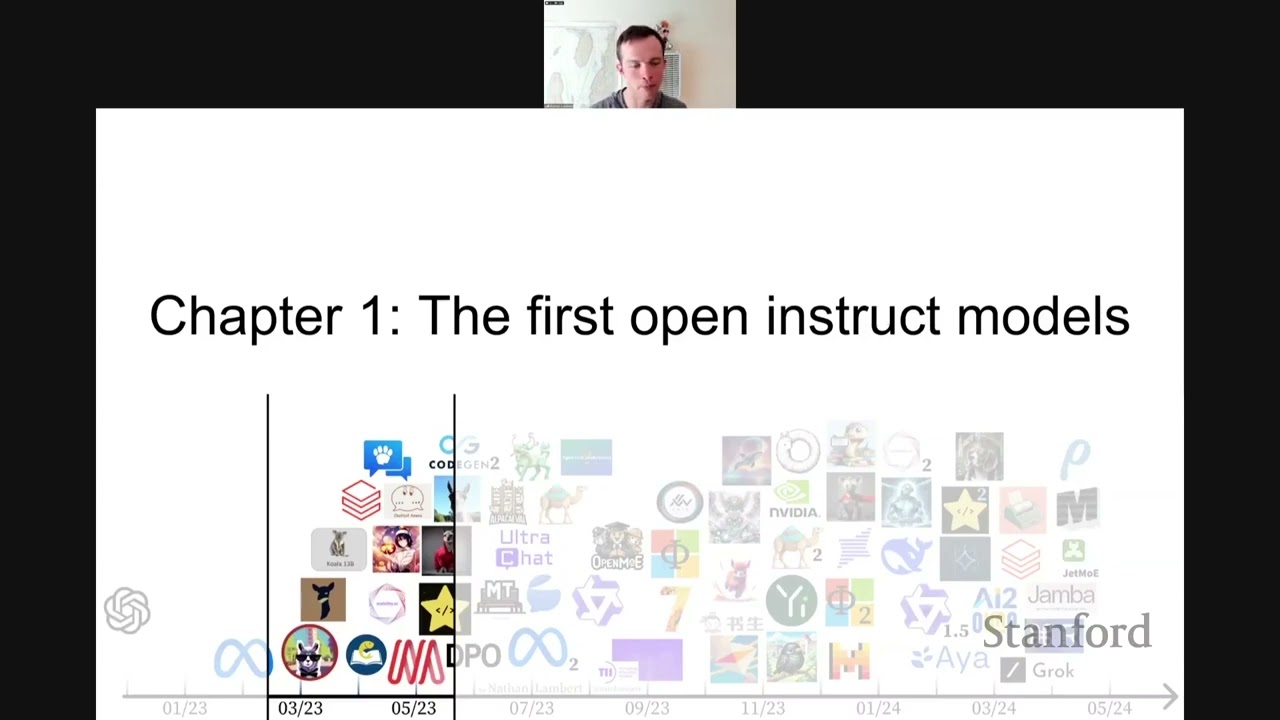

Phần 1: Lịch sử và bối cảnh

- Video bắt đầu bằng việc giới thiệu lịch sử phát triển của các mô hình ngôn ngữ, từ những nghiên cứu ban đầu của Claude Shannon đến sự ra đời của Transformer và các mô hình như GPT và BERT.

- Video nhấn mạnh tầm quan trọng của việc đào tạo các mô hình ngôn ngữ trên các tập dữ liệu lớn và các vấn đề về an toàn khi phát hành các mô hình này.

- Video cũng đề cập đến sự ra đời của ChatGPT và tác động của nó đến lĩnh vực AI, thúc đẩy sự phát triển của các kỹ thuật căn chỉnh mô hình.

Phần 2: Căn chỉnh mô hình bằng cách sử dụng kỹ thuật huấn luyện trực tiếp (Instruction Tuning)

- Video giới thiệu khái niệm huấn luyện trực tiếp (Instruction Tuning), một kỹ thuật được sử dụng để huấn luyện các mô hình ngôn ngữ phản hồi tốt hơn với các câu lệnh và yêu cầu của người dùng.

- Video thảo luận về các mô hình đầu tiên sử dụng kỹ thuật này, bao gồm Alpaca, Vicuna và Koala.

- Video cũng đề cập đến vai trò của tập dữ liệu và việc sử dụng các mô hình ngôn ngữ mạnh hơn để tạo ra tập dữ liệu tổng hợp cho huấn luyện.

Phần 3: Căn chỉnh mô hình bằng cách sử dụng kỹ thuật tối ưu hóa trực tiếp ưu tiên (DPO)

- Video giới thiệu khái niệm DPO, một kỹ thuật đơn giản và hiệu quả để căn chỉnh các mô hình ngôn ngữ bằng cách tối ưu hóa trực tiếp hàm mất mát dựa trên ưu tiên của người dùng.

- Video thảo luận về các mô hình sử dụng DPO, bao gồm Zephyr và các mô hình được phát triển bởi AI2.

- Video cũng đề cập đến các điểm mạnh và điểm yếu của DPO so với các kỹ thuật khác như PPO.

Phần 4: Căn chỉnh mô hình bằng cách sử dụng kỹ thuật tối ưu hóa chính sách (PPO)

- Video giới thiệu khái niệm PPO, một kỹ thuật được sử dụng để tối ưu hóa chính sách của mô hình ngôn ngữ dựa trên phản hồi của người dùng.

- Video thảo luận về các mô hình sử dụng PPO, bao gồm Starling LM Alpha và các mô hình được phát triển bởi Nvidia.

- Video cũng đề cập đến các điểm mạnh và điểm yếu của PPO so với các kỹ thuật khác như DPO.

Phần 5: Thảo luận về tương lai của việc căn chỉnh các mô hình ngôn ngữ mở

- Video thảo luận về các thách thức và cơ hội trong việc căn chỉnh các mô hình ngôn ngữ mở, bao gồm việc tạo ra các tập dữ liệu chất lượng cao, phát triển các kỹ thuật đánh giá hiệu quả và giải quyết các vấn đề về an toàn.

- Video cũng đề cập đến vai trò của các công ty và cá nhân trong việc thúc đẩy sự phát triển của lĩnh vực này.

- Video kết thúc bằng việc khẳng định tầm quan trọng của việc tiếp tục nghiên cứu và phát triển các kỹ thuật căn chỉnh mô hình ngôn ngữ mở để tạo ra các mô hình có khả năng tương tác tốt hơn với người dùng và giải quyết các vấn đề về an toàn.