CS 194/294-280 (Advanced LLM Agents) - Lecture 2, Jason Weston

Tóm tắt ngắn:

- Bài thuyết trình tập trung vào chủ đề cải thiện khả năng lập luận của các mô hình ngôn ngữ lớn (LLM) thông qua tự học và tự cải thiện.

- Các điểm chính bao gồm việc sử dụng hai hệ thống lập luận (hệ thống 1 phản xạ và hệ thống 2 có chủ đích), kỹ thuật gợi ý (prompting) như Chain of Thought, học tăng cường từ phản hồi của AI (RLHF), tối ưu hóa ưu tiên trực tiếp (DPO), và các phương pháp tự thưởng (self-rewarding) để huấn luyện LLM tự đánh giá và cải thiện hiệu suất. Các ví dụ cụ thể bao gồm mô hình GPT, InstructGPT, BlenderBot, và các nghiên cứu gần đây về mô hình tự thưởng và mô hình DeepSeek.

- Ứng dụng và ý nghĩa bao gồm việc tạo ra các LLM có khả năng lập luận vượt trội, giải quyết các vấn đề như ảo giác, sai lệch ngữ nghĩa, và cải thiện khả năng theo hướng dẫn. Điều này có thể dẫn đến sự phát triển của AI siêu việt.

- Các quy trình và phương pháp được mô tả chi tiết bao gồm đào tạo vòng lặp (iterative training), tạo cặp ưu tiên (preference pairs) cho DPO, và sử dụng LLM làm người đánh giá (LLM as a judge) để tự đánh giá và tự thưởng.

Tóm tắt chi tiết:

Bài thuyết trình được chia thành các phần chính sau:

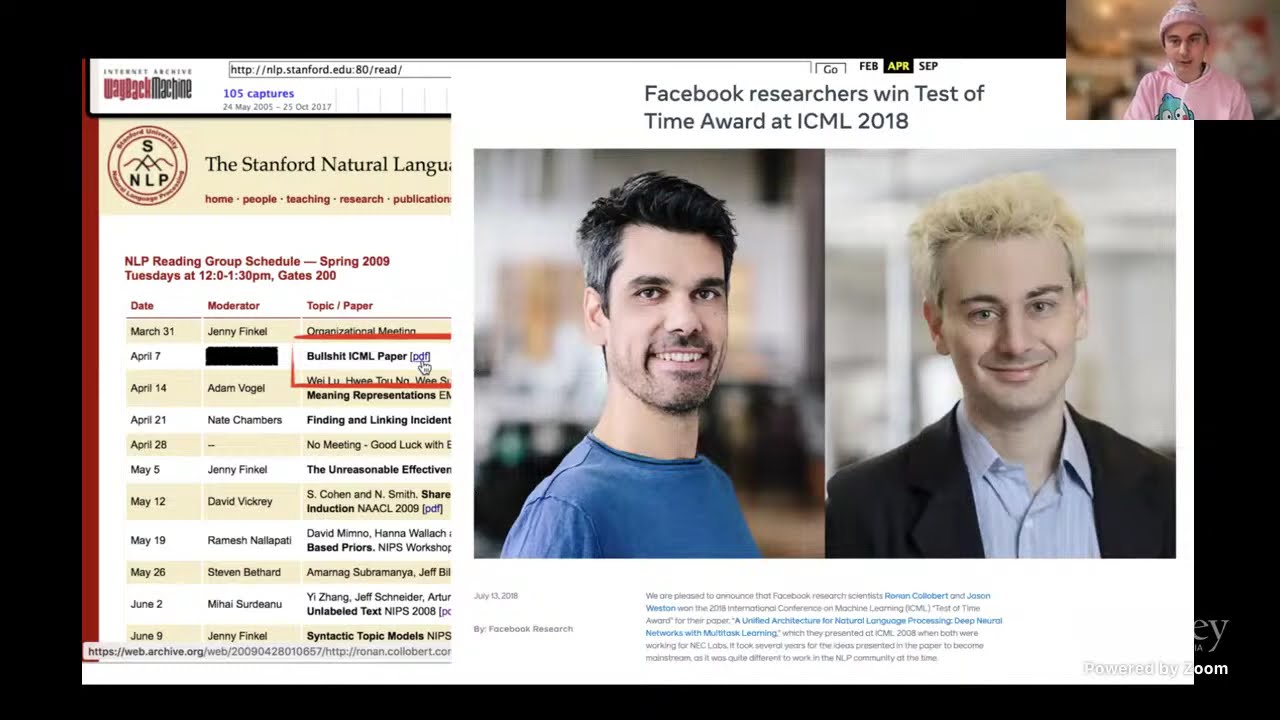

Phần 1: Giới thiệu và bối cảnh: Giáo sư Jason Weston bắt đầu bằng việc nhấn mạnh sự phát triển nhanh chóng của AI và LLM trong những năm gần đây, đặc biệt là sự ra đời của Chain of Thought (CoT) vào năm 2022. Ông đặt ra câu hỏi nghiên cứu chính: Liệu LLM có thể tự huấn luyện để đạt đến khả năng siêu việt hay không?

Phần 2: Hai hệ thống lập luận: Ông phân biệt hai hệ thống lập luận: hệ thống 1 (phản xạ, dựa trên liên kết) và hệ thống 2 (có chủ đích, nỗ lực). Hệ thống 1 được thể hiện bởi chính mạng nơ-ron của LLM, trong khi hệ thống 2 được mô phỏng bằng việc tạo ra chuỗi suy luận (Chain of Thought) trước khi đưa ra câu trả lời cuối cùng. Ông chỉ ra các hạn chế của LLM hiện tại như ảo giác và sai lệch, và hệ thống 2 được dùng để khắc phục những hạn chế này.

Phần 3: Lịch sử phát triển LLM: Phần này tóm tắt lịch sử phát triển của LLM, từ các mô hình đơn giản ban đầu đến các mô hình Transformer hiện đại. Ông đề cập đến các công trình nghiên cứu quan trọng, bao gồm công trình của Bengio năm 2003, công trình của Weston và cộng sự năm 2008, và sự ra đời của cơ chế attention và Transformer. Ông nhấn mạnh "giả thuyết mở rộng quy mô" (scaling hypothesis) – mô hình lớn hơn, dữ liệu lớn hơn dẫn đến hiệu quả tốt hơn.

Phần 4: Huấn luyện LLM vượt quá mục tiêu mô hình ngôn ngữ: Phần này tập trung vào các phương pháp huấn luyện LLM phức tạp hơn, vượt ra ngoài mục tiêu dự đoán từ tiếp theo. Ông đề cập đến học tăng cường từ phản hồi của con người (RLHF), tối ưu hóa ưu tiên trực tiếp (DPO), và việc sử dụng mô hình thưởng (reward model). InstructGPT được đưa ra làm ví dụ về việc sử dụng RLHF.

Phần 5: Kỹ thuật gợi ý và lập luận chuỗi suy nghĩ: Ông thảo luận về các kỹ thuật gợi ý (prompting) như few-shot prompting và Chain of Thought prompting để thúc đẩy LLM tạo ra chuỗi suy luận. Ông trình bày các ví dụ về việc sử dụng CoT để giải quyết các bài toán toán học và khắc phục các vấn đề về tính xác thực và ảo giác. Kỹ thuật Chain of Verification được giới thiệu để kiểm tra tính chính xác của câu trả lời.

Phần 6: Mô hình tự thưởng: Phần này giới thiệu khái niệm mô hình tự thưởng (self-rewarding language models), trong đó LLM tự đánh giá và tự thưởng cho đầu ra của chính nó. Ông giải thích lý do tại sao phương pháp này là cần thiết khi LLM trở nên mạnh mẽ hơn con người trong một số lĩnh vực. Ông trình bày chi tiết về quy trình đào tạo vòng lặp, sử dụng LLM làm người đánh giá, và tạo cặp ưu tiên cho DPO. Kết quả thí nghiệm trên mô hình Llama 70B được trình bày, cho thấy sự cải thiện hiệu suất đáng kể.

Phần 7: Tối ưu hóa ưu tiên lập luận lặp lại và DeepSeek: Ông trình bày về Iterative Reasoning Preference Optimization (IRPO), một phương pháp sử dụng CoT và phần thưởng có thể kiểm chứng để cải thiện khả năng lập luận của LLM, đặc biệt là trong các bài toán toán học. Ông so sánh với mô hình DeepSeek của Google, cho thấy sự tương đồng về phương pháp.

Phần 8: Tối ưu hóa ưu tiên suy nghĩ và các hướng nghiên cứu tương lai: Ông giới thiệu Thought Preference Optimization (TPO), một phương pháp mở rộng IRPO cho các nhiệm vụ ngoài toán học. Ông thảo luận về việc cải thiện khả năng tự đánh giá của LLM thông qua meta-judging và việc tạo dữ liệu đánh giá có thể kiểm chứng. Cuối cùng, ông đề cập đến các hướng nghiên cứu trong tương lai, bao gồm việc sử dụng vector thay vì token trong chuỗi suy luận và việc cải thiện cả hệ thống 1 và hệ thống 2 của LLM.

Lưu ý: Bản tóm tắt này cố gắng giữ nguyên ý chính và các ví dụ cụ thể trong bài thuyết trình gốc. Tuy nhiên, do độ dài của bản ghi, một số chi tiết kỹ thuật nhỏ có thể bị bỏ sót.