CS 194/294-280 (Advanced LLM Agents) - Lecture 1, Xinyun Chen

Tóm tắt ngắn:

- Bài giảng giới thiệu về các agent LLM nâng cao, tập trung vào kỹ thuật cải thiện khả năng lập luận (reasoning) của các mô hình ngôn ngữ lớn (LLM) tại thời điểm suy luận (inference time).

- Các điểm chính bao gồm: sử dụng kỹ thuật chain-of-thought prompting để kích hoạt quá trình suy luận chi tiết, phương pháp self-consistency để chọn đáp án tốt nhất từ nhiều lựa chọn, và các kỹ thuật tự cải tiến (iterative self-improvement) để sửa lỗi và tối ưu hóa đáp án. Các công nghệ và ví dụ cụ thể được đề cập đến như mô hình OpenAI, Gemini, AlphaCode, và các bài toán toán học, lập trình.

- Ứng dụng của các kỹ thuật này bao gồm tạo mã, trợ lý cá nhân, robot học, và nhiều lĩnh vực khác như giáo dục, tài chính. Khả năng lập luận của AI được cải thiện đáng kể, đạt được kết quả cạnh tranh với con người trong một số lĩnh vực.

- Các phương pháp được mô tả chi tiết bao gồm: thiết kế prompt, lựa chọn đáp án dựa trên tính nhất quán, và các vòng lặp tự cải tiến.

Tóm tắt chi tiết:

Bài giảng được chia thành các phần chính sau:

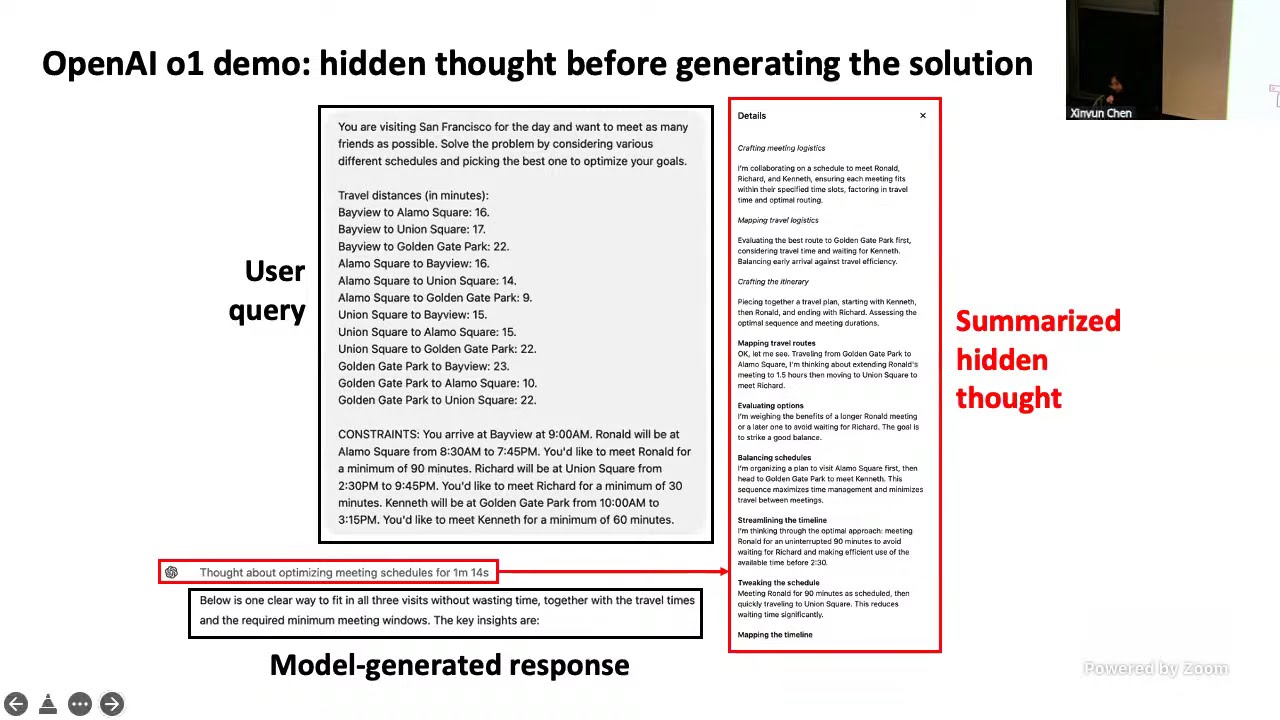

Phần 1: Giới thiệu và Kỹ thuật Prompting cơ bản: Giảng viên Xinyun Chen giới thiệu về khóa học "Advanced Large Language Model Agents" và nhấn mạnh sự phát triển nhanh chóng của các mô hình lập luận LLM trong năm 2024-2025, ví dụ như OpenAI và Gemini. Ông trình bày khái niệm agent LLM, nơi LLM đóng vai trò bộ não, lập luận, lập kế hoạch và tương tác với môi trường. Phần này tập trung vào kỹ thuật chain-of-thought (CoT) prompting, kỹ thuật này cải thiện đáng kể khả năng lập luận của LLM bằng cách đưa vào các ví dụ với quá trình suy luận chi tiết (step-by-step). Giảng viên so sánh CoT prompting với prompting tiêu chuẩn và chỉ ra rằng các mô hình lớn hơn hưởng lợi nhiều hơn từ CoT. Ông cũng đề cập đến analogical prompting, một phương pháp cho phép mô hình tự tạo ra các ví dụ liên quan để giải quyết bài toán, loại bỏ sự cần thiết của việc gán nhãn thủ công. Một điểm nhấn quan trọng là việc sử dụng LLM để tự động thiết kế prompt, tối ưu hóa quá trình này.

Phần 2: Tìm kiếm và lựa chọn từ nhiều ứng viên: Phần này tập trung vào việc tăng số lượng đáp án được tạo ra để tăng khả năng tìm ra đáp án chính xác. Kỹ thuật self-consistency được giới thiệu, phương pháp này chọn đáp án xuất hiện nhiều nhất trong các đáp án được tạo ra. Giảng viên phân tích hiệu quả của self-consistency và chỉ ra rằng nó hoạt động tốt hơn so với việc xếp hạng dựa trên xác suất. Ứng dụng của self-consistency trong AlphaCode (hệ thống lập trình cạnh tranh) cũng được đề cập. Universal self-consistency được giới thiệu như một mở rộng, cho phép lựa chọn đáp án tốt nhất mà không cần trích xuất câu trả lời. Cuối cùng, việc huấn luyện một mô hình riêng biệt để xếp hạng các đáp án cũng được thảo luận.

Phần 3: Tự cải tiến lặp lại: Phần này tập trung vào việc sử dụng LLM để tự cải tiến đáp án thông qua các vòng lặp. Các kỹ thuật như reflection và self-refinement được đề cập, cho phép mô hình phản hồi và điều chỉnh đáp án dựa trên phản hồi từ môi trường hoặc đánh giá nội bộ. Giảng viên cũng thảo luận về việc sử dụng self-debugging trong việc tạo mã, nơi mô hình tự sửa lỗi dựa trên phản hồi khác nhau (unit test, code explanation, trace feedback). Tuy nhiên, ông cũng trình bày kết quả nghiên cứu cho thấy LLM hiện tại vẫn gặp khó khăn trong việc tự đánh giá chính xác và tự sửa lỗi mà không cần phản hồi từ bên ngoài. Cuối cùng, ông thảo luận về việc cân bằng giữa việc tạo nhiều đáp án song song và tuần tự để tối ưu hóa việc sử dụng tài nguyên tính toán. Ông nhấn mạnh tầm quan trọng của việc lựa chọn mô hình phù hợp với ngân sách tính toán và độ khó của bài toán.

Kết luận: Giảng viên kết thúc bằng cách trích dẫn bài viết "The Bitter Lesson" của Richard Sutton, nhấn mạnh tầm quan trọng của việc phát triển các phương pháp có thể mở rộng quy mô với lượng tính toán ngày càng tăng và khả năng tự học hỏi, tự cải tiến của mô hình. "Chúng ta muốn dạy mô hình khám phá ra những gì chúng ta không biết, chứ không phải những gì chúng ta đã biết." Đây là một triết lý quan trọng trong việc phát triển các kỹ thuật lập luận hiệu quả cho LLM.