Link to original video by Duy Luân Dễ Thương

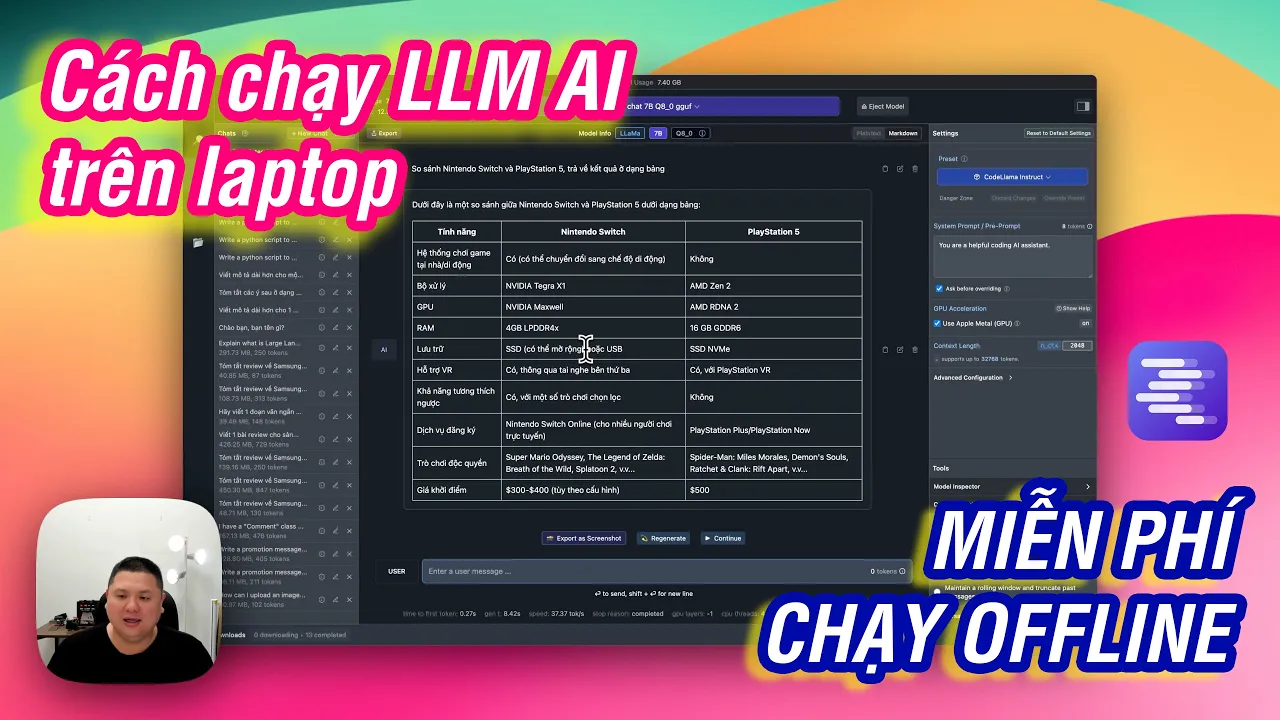

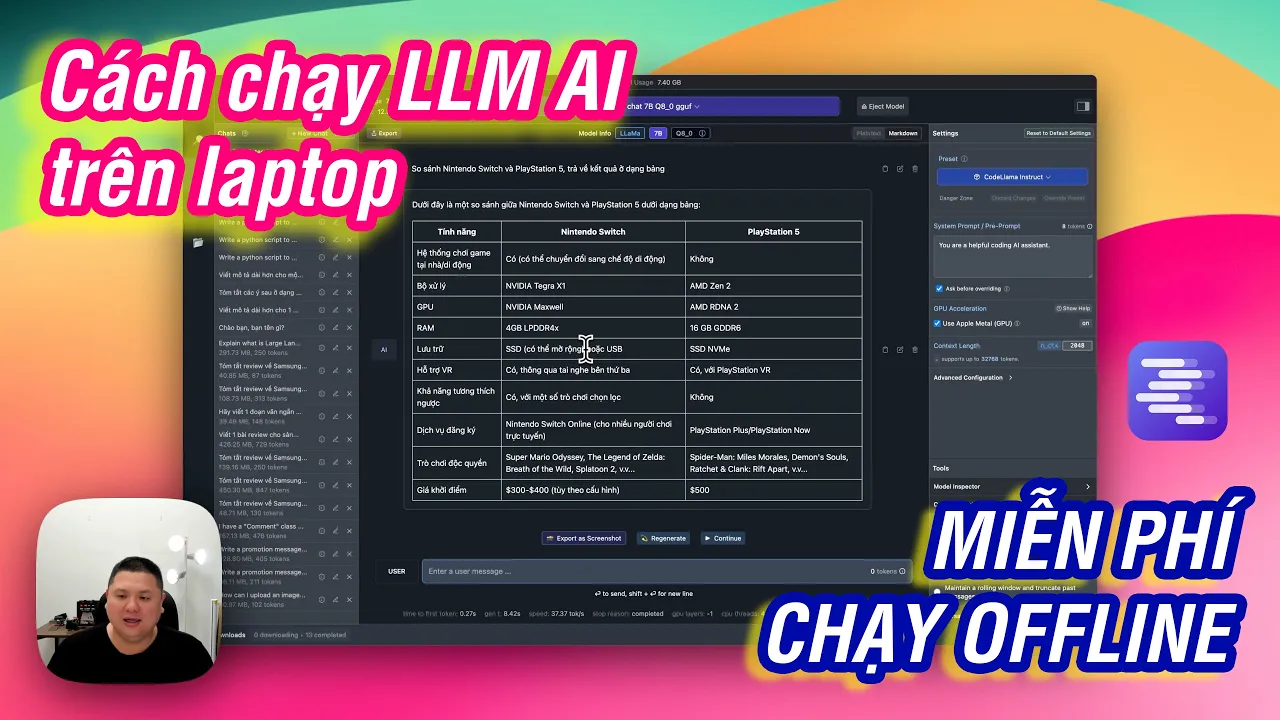

Hướng dẫn chạy AI LLM miễn phí, offline trên PC, cả Windows / Mac đều dùng tốt

Tóm tắt video "Hướng dẫn chạy AI LLM miễn phí, offline trên PC, cả Windows / Mac đều dùng tốt"

Tóm tắt ngắn:

- Video giới thiệu về cách chạy các mô hình ngôn ngữ lớn (LLM) AI trực tiếp trên máy tính cá nhân mà không cần internet, đảm bảo quyền riêng tư và bảo mật.

- Video tập trung vào phần mềm miễn phí LM Studio, cho phép chạy các LLM như ChatGPT, Bard, và các mô hình khác trên Windows, Mac và Linux.

- Chạy LLM trực tiếp trên máy tính mang lại tốc độ generate nhanh hơn, miễn phí, bảo mật dữ liệu và cho phép thử nghiệm nhiều mô hình khác nhau phù hợp với mục đích sử dụng.

- Video hướng dẫn cách tải và sử dụng LM Studio, bao gồm tìm kiếm và download các mô hình, sử dụng các tính năng chat, tạo bảng, và code generation.

Tóm tắt chi tiết:

Phần 1: Giới thiệu về chạy AI LLM offline

- Video giới thiệu về việc chạy các mô hình ngôn ngữ lớn (LLM) AI trực tiếp trên máy tính cá nhân mà không cần internet.

- Nêu bật lợi ích của việc chạy LLM offline: tốc độ nhanh hơn, miễn phí, bảo mật dữ liệu và cho phép thử nghiệm nhiều mô hình khác nhau.

- Ví dụ: ChatGPT, Bard, và các mô hình chuyên biệt khác.

Phần 2: Giới thiệu phần mềm LM Studio

- Giới thiệu phần mềm LM Studio, một phần mềm miễn phí cho phép chạy các LLM trên Windows, Mac và Linux.

- Nêu bật điểm mạnh của LM Studio: giao diện thân thiện, dễ sử dụng, hỗ trợ nhiều mô hình AI khác nhau.

Phần 3: Hướng dẫn tải và sử dụng LM Studio

- Hướng dẫn cách tải và cài đặt LM Studio.

- Hướng dẫn cách tìm kiếm và download các mô hình AI trên Hugging Face, một kho lưu trữ các mô hình AI lớn.

- Hướng dẫn cách sử dụng LM Studio để chat, tạo bảng, và code generation.

- Giải thích về các tính năng của LM Studio: system prompt, GPU acceleration, markdown output.

- Nêu bật cách sử dụng GPU để tăng tốc độ generate.

Phần 4: Chia sẻ kinh nghiệm sử dụng LM Studio

- Chia sẻ kinh nghiệm sử dụng LM Studio với các mô hình AI khác nhau.

- Khuyến nghị các mô hình phù hợp với các mục đích sử dụng khác nhau: chat tiếng Việt (Vrun), code generation (Code Llama), và small language model (Phi-2).

- Nêu bật sự khác biệt giữa CPU inference và GPU inference, và cách lựa chọn phù hợp với cấu hình máy tính.

- Chia sẻ kinh nghiệm sử dụng LM Studio trên các thiết bị khác nhau: ASUS Zenbook 14 oled, THB B1 gen6, Macbook Air M2, Macbook Pro M3 Max.

- Nêu bật ưu điểm của Macbook với kiến trúc unified memory cho phép sử dụng GPU inference hiệu quả.

Kết luận:

- Video khẳng định việc chạy AI LLM offline trên máy tính cá nhân là một giải pháp hiệu quả, an toàn và tiết kiệm.

- Khuyến khích người xem tải và trải nghiệm LM Studio để ứng dụng AI một cách hiệu quả hơn.